摩尔线程在国际顶级人工智能会议 AAAI 2026 上正式发布其自主研发的 URPO(统一奖励与策略优化)框架。该框架通过将“指令遵循”与“奖励评判”两大功能融合于单一模型中,首次实现生成与评估能力的同步优化,显著提升大语言模型的训练效率与性能。

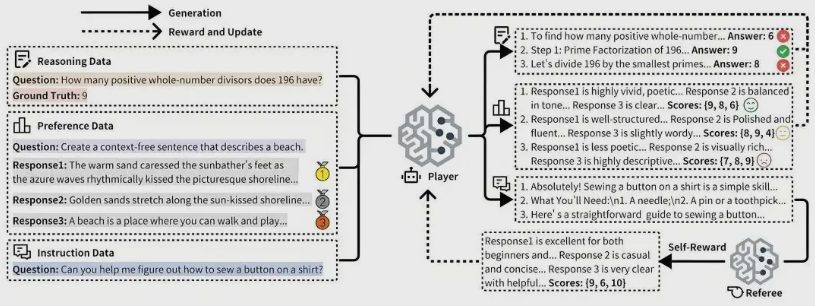

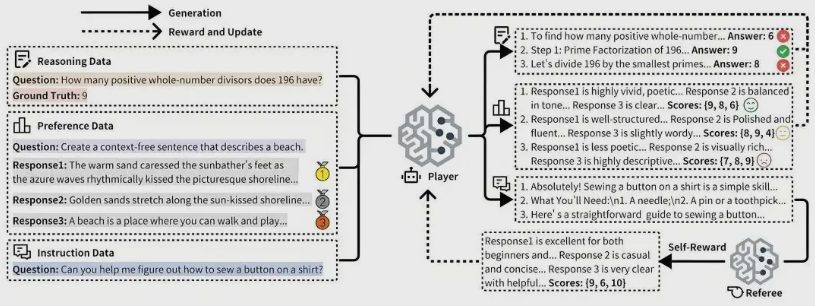

URPO 框架攻克了三大关键技术难题:一是统一偏好数据、推理验证数据与开放式指令数据的格式,构建通用训练信号;二是引入自我奖励机制,使模型在生成多个候选回答后可自主评分并用于策略优化;三是设计协同进化算法,动态平衡多类数据训练比例,推动生成与评判能力共同提升。

基于 Qwen2.5-7B 模型的实验显示,URPO 在 AlpacaEval 指令跟随评测中得分提升至 44.84,在综合推理测试中平均分提高 3 分,并在 RewardBench 奖励模型评测中以 85.15 分超越专用奖励模型,展现出卓越的内生评估能力。

目前,URPO 已完成与摩尔线程自研计算卡的深度适配,并无缝集成主流强化学习框架 VERL。实测表明,该方案可提升计算资源利用率 40%,缩短训练周期 35%,为大规模模型高效部署提供全新路径。