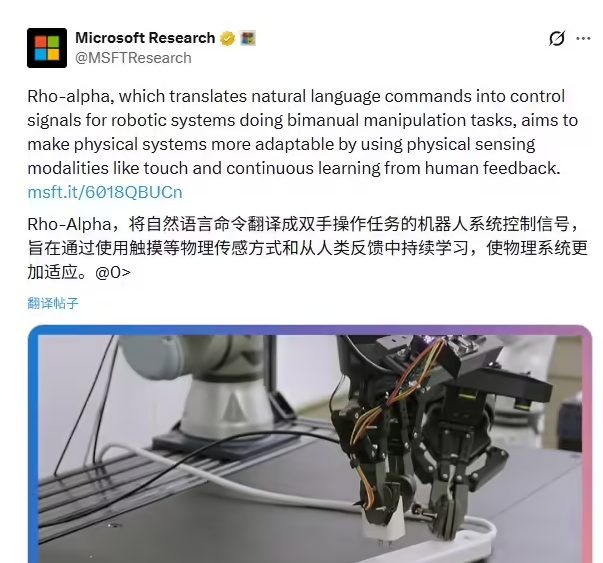

微软研究院正式推出面向机器人领域的全新AI基础模型——Rho-alpha。作为微软“物理 AI”战略的核心成果,该模型旨在让机器人摆脱对封闭、预设环境的依赖,真正适应复杂、动态的真实世界。

Rho-alpha 基于 Phi 视觉-语言模型家族构建,首次深度融合视觉、自然语言与触觉感知,可将人类口语指令直接转化为精准的机器人控制信号,支持高难度的双手协同操作。其内置的触觉反馈机制使机器人能根据实际接触实时调整抓取力度与姿态,未来还将集成力感知等多模态输入以提升操作精度。

此外,Rho-alpha 具备持续学习能力:用户可通过3D输入设备实时干预机器人行为,系统将即时吸收反馈并优化策略。模型训练融合了Azure生成的海量仿真数据与真实世界演示,有效缓解现实场景数据稀缺难题。

目前,Rho-alpha 正在双臂及类人机器人平台上进行测试,并计划通过早期访问计划向全球研究机构开放,加速“物理 AI”从实验室走向产业落地。