|

Meta最近发布了三篇详尽的Llama微调指南,旨在帮助用户更好地理解和应用这些大型语言模型。这些指南详细介绍了如何微调Llama模型,包括全面微调、LORA和QLoRA等方法,并提供了针对不同应用场景的优化建议。

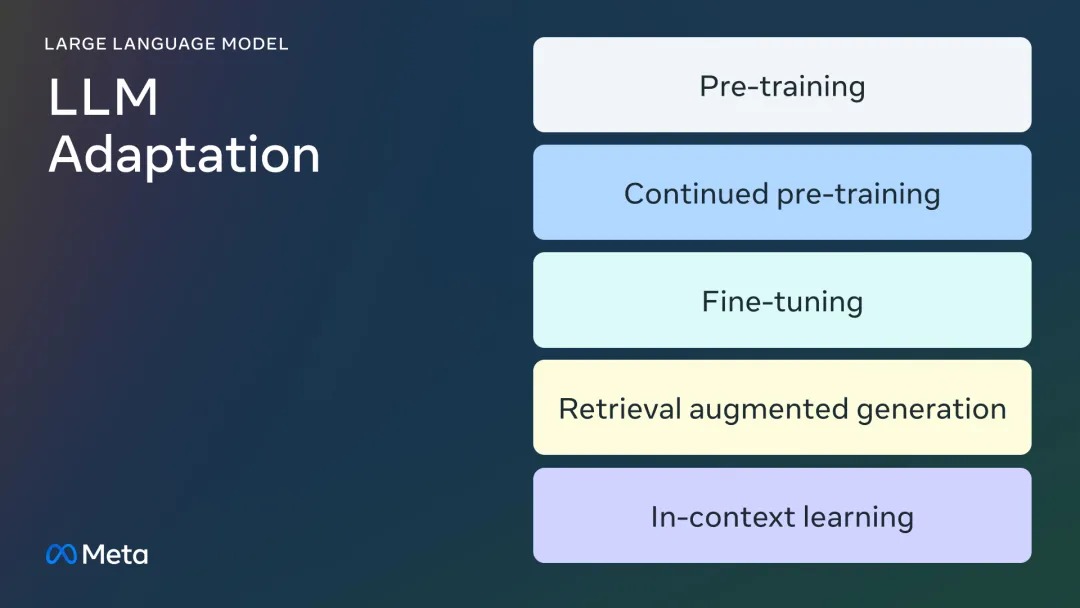

这些指南强调了在使用Llama模型时,如何利用特定领域数据进行微调,以适应特定的用例。例如,通过使用XLMR和BERT等小模型进行传统微调,以及对Llama 2和GPT3等大模型进行更复杂的微调。此外,指南还讨论了如何管理训练过程中的资源,例如GPU内存的使用,以及如何避免灾难性遗忘等问题。 Meta的这些指南不仅适用于有经验的开发者,也适合初学者。例如,指南中提到的全面微调方法包括更改模型的所有参数,这在小模型如XLMR和BERT上是常见的做法,而在大模型如Llama 2和GPT3上则需要更复杂的策略。 这些指南的发布,标志着Meta在推动大型语言模型的开源和应用方面迈出了重要一步。通过提供详细的微调指南,Meta不仅增强了Llama模型的可用性,还促进了学术界和工业界对这些模型的研究和应用。 |